1.安装Ollama的AMD版本

如果你是AMD显卡,你应该下载Ollama的AMD版本,否则大模型会在CPU上运行,推理效率低。

下载地址:https://github.com/likelovewant/ollama-for-amd/?tab=readme-ov-file

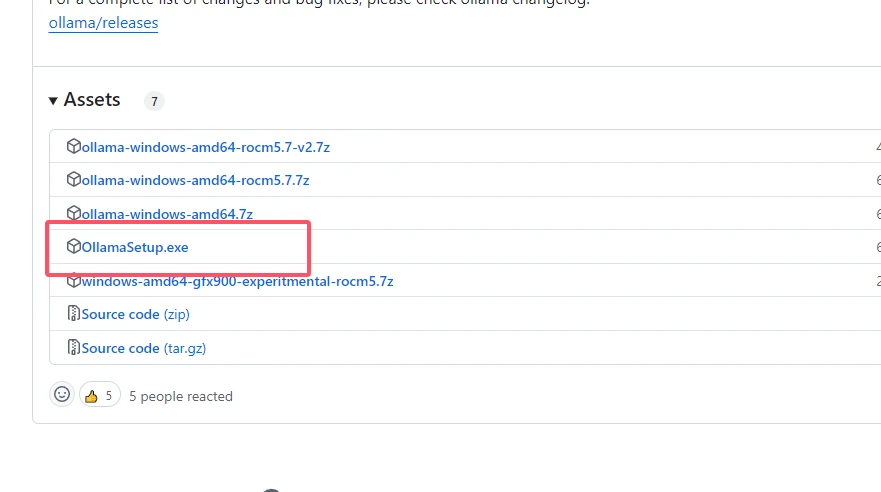

打开后点击右侧Releases标签,进入软件列表,将页面拖至最低部,直接下载第四个OllamaSetup.exe安装包即可

2、在CMD终端下通过命令下载DeepSeek R1

根据自己电脑的显存大小选择适合自己的模型

1.5b模型:ollama run deepseek-r1:1.5b

7b模型:ollama run huihui_ai/deepseek-r1-abliterated:7b

8b模型:ollama run huihui_ai/deepseek-r1-abliterated:8b

14b模型:ollama run huihui_ai/deepseek-r1-abliterated:14b

32b模型:ollama run huihui_ai/deepseek-r1-abliterated:32b

70b模型:ollama run huihui_ai/deepseek-r1-abliterated:70b

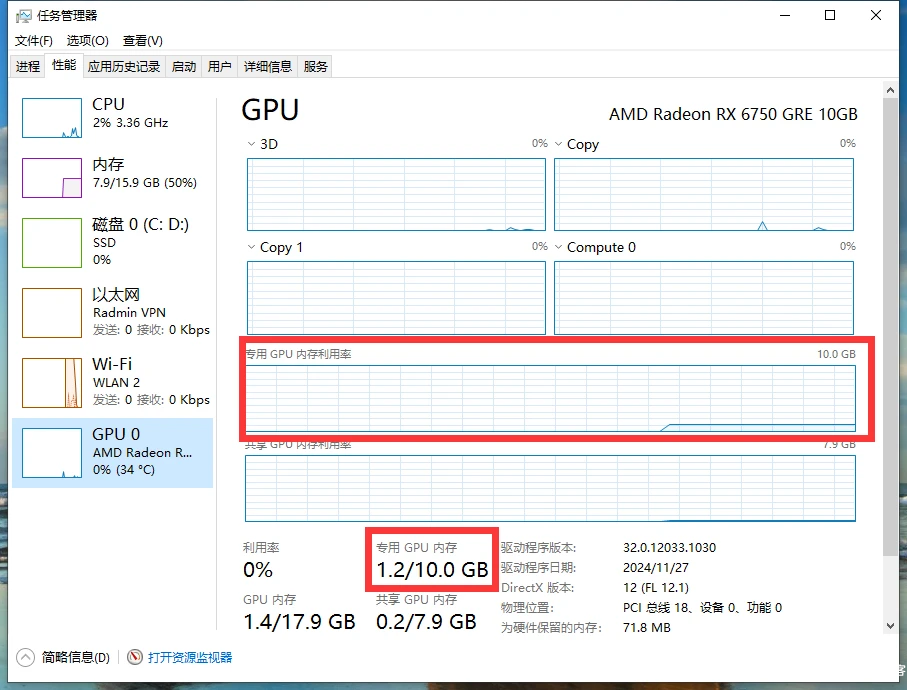

调出任务管理器查看显卡占用情况

观察专用显存占用情况,如果很低,证明DeepSeek没有在显卡中运行

此时你需要替换部分文件,才能修复此问题。

访问github:v0.6.1.2

根据你的显卡类型,下载对应的文件:

例:我的显卡是6750 GRE 就下载:rocm.gfx1031.for.hip.sdk.6.1.2.7z

下载完成后,将解压的内容分别对应替换:

C:\Users\你的用户名\AppData\Local\Programs\Ollama\lib\ollama\rocblas.dll

C:\Users\你的用户名\AppData\Local\Programs\Ollama\lib\ollama\rocblas\library

5、重启Ollama

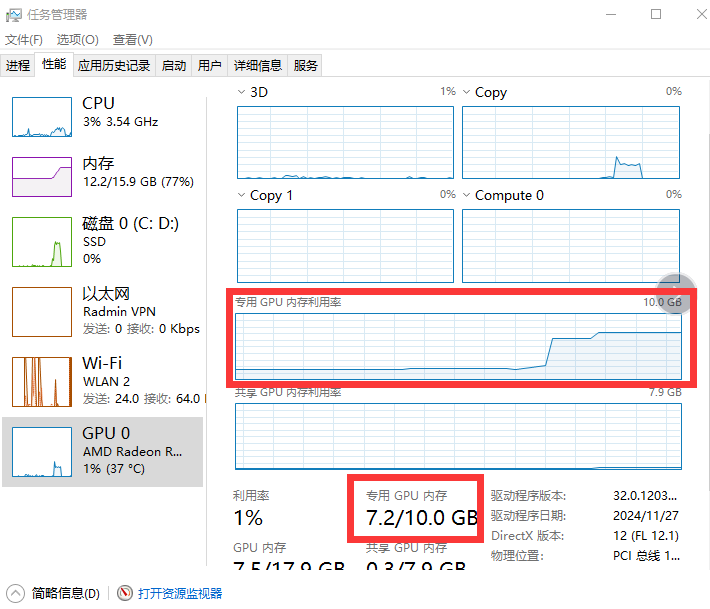

重启后再次查看任务管理器,如果专用显存占用有提升,说明DeepSeek已经在显卡中运行。

本文转载自 AMD显卡如何本地部署DeepSeek – 番茄窝子-建站教程-学习笔记-番茄酱-无人问津的小站-浮梦技术窝 (fqidc.cn)

暂无评论内容